想让搜索引擎更懂你的WordPress网站?合理设置robots.txt文件是关键! 这个不起眼的文件就像网站的地图导航,能智能引导搜索引擎抓取重要内容,避开无关页面,可以减轻服务器负担和提升SEO效果。本文会用Yoast SEO插件轻松配置robots.txt,让爬虫精准抓取,优化网站收录效果。

1. 什么是 robots.txt?

robots.txt 是网站根目录下的纯文本文件,用来告诉搜索引擎爬虫哪些页面可以抓取,哪些页面禁止抓取。

基本语法包括:

User-agent: [爬虫名称]

Disallow: [禁止抓取的路径]

Allow: [允许抓取的路径]例如:

User-agent: *

Disallow: /wp-admin/

Allow: /wp-admin/admin-ajax.php这表示禁止所有爬虫抓取 wp-admin 后台,但允许抓取 admin-ajax.php 文件。

2. 为什么 robots.txt 配置很重要?

- 提升抓取效率

防止爬虫浪费抓取预算在重复或无价值页面上。

- 保护隐私内容

阻止搜索引擎访问敏感路径,如后台或系统文件。

- 防止重复内容收录

配合 noindex 使用,可以避免重复或无意义页面影响 SEO。

但要注意,robots.txt 只是爬虫的“请求”,部分恶意爬虫还可能无视其规则。

3. Yoast SEO 与 robots.txt 的关系

Yoast SEO 本身不直接生成 robots.txt 文件,但它提供了一个编辑 robots.txt 的便捷入口,让你不用通过 FTP 修改服务器文件。

如何通过 Yoast SEO 编辑 robots.txt?

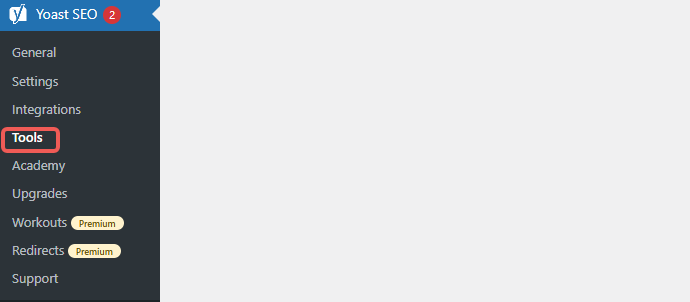

- 登录 WordPress 后台

- 点击左侧菜单 Yoast SEO > 工具(Tools)

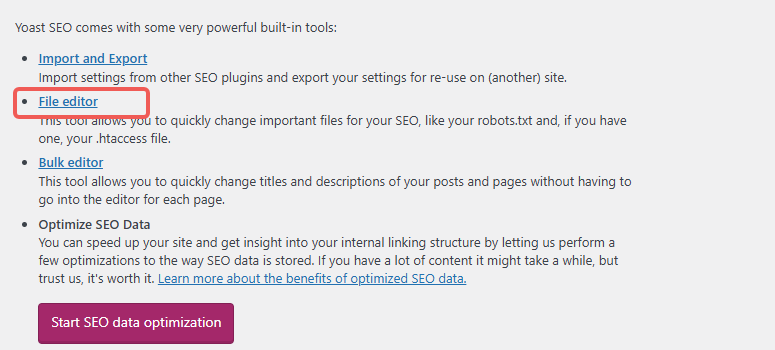

- 选择 文件编辑器(File editor)

- 如果你的 WordPress 有写入权限,会看到 robots.txt 编辑框

- 在这里输入你的爬虫规则,点击【保存更改】即可生效

如果提示不能编辑,需要通过 FTP 或主机控制面板手动创建 robots.txt 文件。

4. robots.txt 配置常用示例

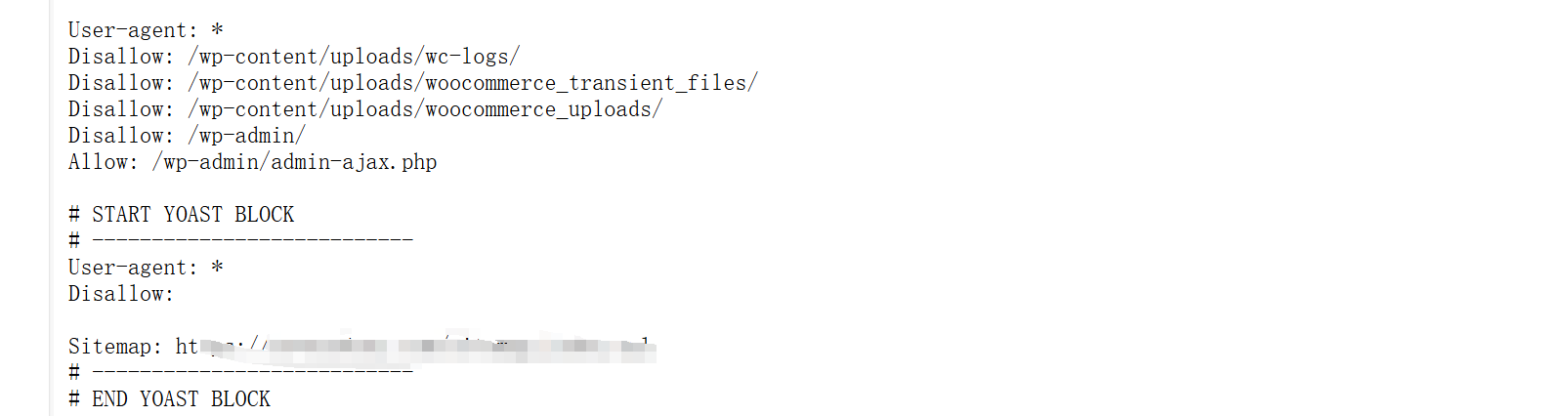

下面是常见的 WordPress robots.txt 配置示例,可根据网站结构进行调整:

4.1 基础配置

User-agent: *

Disallow: /wp-admin/

Allow: /wp-admin/admin-ajax.php此配置禁止爬虫抓取后台目录,但允许 Ajax 请求文件。

4.2 屏蔽插件目录

如果希望隐藏插件目录,可以添加:

Disallow: /wp-content/plugins/但一般不建议完全禁止,除非确定这些路径不影响前端功能。

4.3 允许全部抓取

如果希望爬虫可以抓取网站所有内容:

User-agent: *

Disallow:4.4 屏蔽标签与搜索结果页面

标签(/tag/)和站内搜索结果页面通常对 SEO 价值不高,而且容易造成重复内容,可以禁止抓取:

Disallow: /?s=

Disallow: /tag/注意:如果已为这些页面设置 noindex,也可以保留抓取,避免 Google Search Console 提示“被 robots.txt 阻止抓取的 noindex 页面”警告。

5. 配置 robots.txt 的最佳实践

- 根据实际情况制定规则,避免盲目照搬他人配置

- 不要禁止 CSS 与 JS 文件抓取,否则会影响搜索引擎对页面布局和移动端适配的评估

- 结合 sitemap.xml 提交,在 robots.txt 中添加站点地图链接,例如:

Sitemap: https://www.yoursite.com/sitemap_index.xml

- 配置后,使用 Google Search Console 的 robots.txt 测试工具 检查是否符合预期

- 配合 Yoast SEO 的 noindex 设置,灵活管理页面索引状态

6. 常见配置错误

- 误将全站 Disallow,导致网站无法被索引

- 禁止抓取 wp-content 目录,导致样式与脚本加载异常

- 仅靠 robots.txt 阻止隐私内容,没有设置密码保护,存在安全风险

总结

robots.txt 是网站 SEO 策略中不可忽视的基础配置。Yoast SEO 的文件编辑功能,可以方便地管理 robots.txt,正确引导搜索引擎爬虫,提升抓取效率与整体 SEO 表现。

了解 宝藏号 的更多信息订阅后即可通过电子邮件收到最新文章。 © 版权声明 文章版权归作者所有,未经允许请勿转载。 相关文章 暂无评论... |

|---|